GenAI und die Auswirkungen auf Wissensmanagement

Zurück zum BlogIn den letzten Jahren hat Artificial Intelligence enorme Fortschritte gemacht, insbesondere im Bereich der Generative AI und der Large Language Models (LLM). Diese Technologien haben nicht nur unser Verständnis von Maschinellem Lernen revolutioniert, sondern auch tiefgreifende Auswirkungen auf verschiedene Branchen, darunter das Wissensmanagement.

In diesem Blogbeitrag werfen wir einen genaueren Blick auf den Einfluss und die Veränderungen, die Generative AI auf das Wissensmanagement mit sich bringt.

Was ist Generative AI?

Generative AI bezieht sich auf AI-Systeme, die in der Lage sind, neue Inhalte zu erstellen, die menschenähnlich sind. Diese Systeme basieren auf Deep-Learning-Modellen, wie den sogenannten LLM, von denen GPT-3 und 4, auf denen ChatGPT basiert, das Bekannteste ist. Diese Modelle können aufgrund ihrer umfangreichen Daten und ihrer Architektur menschenähnlichen Text, Bilder, Audio und vieles mehr generieren.

Automatisierte Content-Erstellung

Eine der offensichtlichsten Auswirkungen von Generative AI auf das Wissensmanagement ist die Möglichkeit, hochwertigen Content automatisch zu erstellen. Mit LLM können Unternehmen Artikel, Blogbeiträge, Produktbeschreibungen und sogar wissenschaftliche Arbeiten in kürzester Zeit generieren. Als Basis für wertvollen Content im Sinne eines unternehmensinternen Wissensartikels, bieten sich Informationsobjekte an, in denen Wissen in seiner Rohform erfasst wird. Beispielsweise in Planungs-, Design-, und Berichtssystemen im Vertrieb, in der Entwicklung oder der Projektabwicklung.

Häufig werden hier Werkzeuge wie CRM, Aha!, Figma, Miro, Jira, Confluence oder SharePoint verwendet, um Anforderungen und abgeleitete Produktwünsche der Benutzer zu erfassen, Arbeitspakete abzuleiten und diese in kleine Aufgaben, so genannte Tasks, runterzubrechen, Entwicklungs- und Projektziele festzuhalten und deren Fortschritt zu tracken sowie allgemeine Informationen zu Projekten.

Diese so genannten „System of Records“ sind eine erkenntnisreiche Informationsquelle, die aufgrund tausender Einträge nur leider der Mensch manuell nicht überblicken kann. Und genau an dieser Stelle setzt Generative AI an und unterstützt den Mitarbeitenden bei Fragen wie z. B.:

„Haben wir denn schon mal ein Projekt mit Anforderung X umgesetzt?“

„Wer kennt sich bei uns zu Thema Y aus oder hat sich schon mal Gedanken dazu gemacht?“

„Kommt die Anfrage zu Z häufig aus dem Markt und müssen wir handeln, oder ist das ein Einzelfall?

Large Language Models können hier unterstützen, indem sie die relevanten Informationen aus den Systemen finden, Zusammenfassungen dazu erstellen und dadurch die Antwort auf die Frage liefern. Dies erleichtert im Endeffekt nicht nur den Prozess der Content-Erstellung erheblich, sondern ermöglicht auch eine schnellere Verbreitung von Wissen.

Verbesserte Such- und Indexierungsfunktionen

Generative AI trägt auch dazu bei, die Such- und Indexierungsfunktionen von Wissensmanagement-Systemen zu verbessern und Wissensdatenbanken besser zu organisieren. Durch das Training von AI-Modellen auf große Textmengen können sie semantische Beziehungen erkennen. Diese Beziehungen zeichnen im so genannten Autotagging den Content automatisch mit Metadaten aus und führen zu semantischen Modellen, genannt Knowledge Graphen, die durch Domänenexperten geprüft und verfeinert werden. Die Modelle dienen dazu, inhaltliche Zusammenhänge abzubilden und navigierbar zu machen.

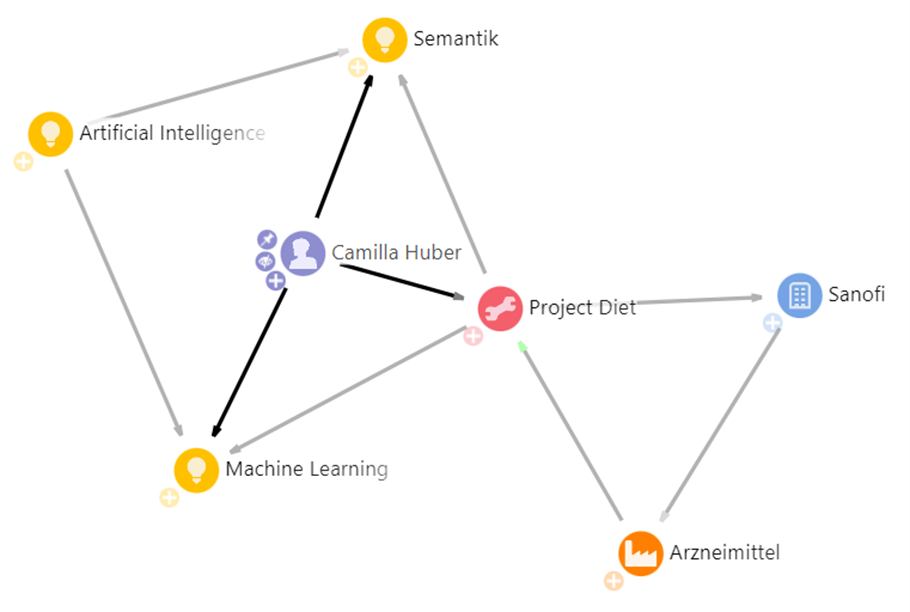

Ein Beispiel ist in folgender Abbildung zu sehen: Camilla Huber arbeitet in Projekt „Diet“, das sich unter anderem mit dem Thema Machine Learning und Semantik beschäftigt. So liefert eine spätere firmenweite Anfrage nach Personen, die sich mit KI-Projekten beschäftigen unter anderem auch Camilla Huber.

Verbesserte Such- und Indexierungsfunktionen durch Large Language Models geht allerdings einher mit einer sehr teuren Analyse, vor allem bei sehr großen Unternehmensbeständen an Information: Die Ablagen von Unternehmen sind meist viele Terrabyte groß. Der Aufbau, sprich: Das Training für ein erweitertes LLM ist aufgrund immenser benötigter GPU-Ressourcen aktuell viel zu teuer im Vergleich zum Mehrwert.

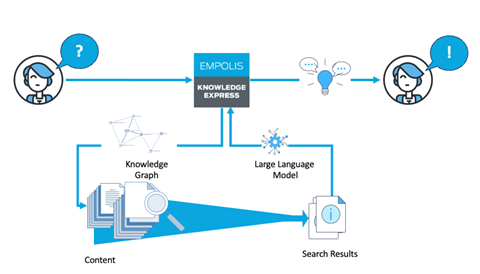

Hierfür gibt es jedoch eine Lösung, die in Kombination mit hochleitungsfähigen semantischen Indextechnologien eine clevere, kostengünstige und von der Qualität her genauso gute Alternative darstellt.

Im ersten Schritt wird die Suche im so genannten „Grounding“ gegen den Knowledge Graph abgesetzt, um den Kontext zu präzisieren (im Beispiel oben der logische Schluss von Semantik und Machine Learning auf AI).

Anschließend wird die verbesserte, also „gegroundete“ Suchanfrage gegen den Dokumentenindex abgesetzt und die besten Dokumente zur gegroundeten Anfrage über weitere AI-Verfahren ermittelt. Diese Top-Treffer werden anschließend als Prompt an das Large Language Model zusammen mit der Anfrage des Nutzers übergeben und aus der Kombination der Treffer eine natürlichsprachliche Antwort generiert. Die LLM-Antwort wiederum kann über den Knowledge Graph überprüft und verfeinert (gegroundet) werden, um dadurch das Halluzinieren der Generative AI zu unterbinden.

Es ist kein Hexenwerk, aber es erscheint dem Nutzenden wie Magie, denn so erhält er die Antwort auf seine Frage statt Dokumententreffer, in denen die Antwort irgendwo steht. Dies führt zu präziseren Suchergebnissen und einer effizienteren Wissensverwaltung.

Personalisierte Benutzererfahrung

Dank Generative AI erzielen Wissensmanagement-Plattformen eine personalisierte Benutzererfahrung. AI-Modelle können das Verhalten der Benutzer analysieren und Inhalte vorschlagen, die für sie am relevantesten sind. Dies fördert die Nutzung der Plattform und erhöht die Effizienz der Wissenssuche.

Automatisierte Übersetzungen und Mehrsprachigkeit

LLM sind auch in der Lage, automatisierte Übersetzungen in Echtzeit durchzuführen. Dies ist ein großer Vorteil für multinationale Unternehmen und Organisationen mit globalen Kunden und Partnern. Die automatisierte Übersetzungsfunktion erleichtert den Austausch von Wissen über Sprachbarrieren hinweg und fördert die Zusammenarbeit.

Herausforderungen bei der Wissensqualität

Obwohl Generative AI das Wissensmanagement revolutioniert hat, bringt sie auch Herausforderungen mit sich. Die automatisierte Content-Erstellung kann zu Fehlern führen, da die Modelle nicht immer in der Lage sind, kontextuelle Nuancen richtig zu erfassen. Dies resultiert in ungenauen Informationen, die fälschlicherweise als korrekt angesehen werden. Deswegen legen wir nahe, die Antworten eines GenAI-Systems immer nur als Empfehlung anzusehen, beispielsweise wie im ersten Use Case dargestellt zur Content-Erzeugung als Input.

Fazit

GenAI und LLM haben zweifellos einen enormen Einfluss auf das Wissensmanagement. Die Automatisierung von Content-Erstellung, verbesserte Suchfunktionen, personalisierte Benutzererfahrung und automatisierte Übersetzungen sind nur einige der Vorteile, die diese Technologien bieten.

Dennoch müssen Organisationen auch die Herausforderungen im Zusammenhang mit der Wissensqualität und Ethik berücksichtigen. Indem wir diese Technologien klug einsetzen und die Qualität der generierten Inhalte sicherstellen, können wir das volle Potenzial der Generative AI für eine effektive Wissensverwaltung nutzen und so einen echten Mehrwert für Unternehmen und die Gesellschaft schaffen.

Der Fortschritt ist ein Quantensprung, in dem die Mitarbeitenden dank der AI-Superkräfte verliehen bekommen und nunmehr kollaborativ gemeinsam mit der Maschine ihre Wissensarbeit mit deutlich besserer Effizienz leisten können und sozusagen eine hybride Intelligenz darstellen.