Ist ChatGPT nun die Lösung für alles?

Zurück zum BlogEin Blogbeitrag von Benedikt Kämpgen.

Eigentlich hat sich nichts geändert: Mit großen Datenmengen und großer Rechenpower zeigen Tiefe Neuronale Netze (Deep Learning) beeindruckende Fähigkeiten. Sie können Bilder, Audio, Video und Texte – oder multimodal mehrere gleichzeitig – scheinbar mit bis zu übermenschlicher Fähigkeit verstehen und eigene Werke erschaffen. Besonders ChatGPT hat auf der ganzen Welt in kurzer Zeit große Begeisterung hervorgerufen. Bei vielen ist dieser Chatbot aktuell der Inbegriff von Künstlicher Intelligenz.

Ist ChatGPT nun die Lösung für alles? Wir möchten einen Überblick geben, um den Einstieg in die Thematik zu vereinfachen sowie Überlegungen und Diskussionen zu unterstützen.

Historie und relevante Bausteine von ChatGPT

Die technologische Grundlage von ChatGPT sind Large Language Models (LLM). Diese sagen die Wahrscheinlichkeit von Wortfolgen, Sätzen o.ä. vorher.

So können LLM nicht nur Basis-Tätigkeiten im Natural Language Processing (NLP) unterstützen (z. B. Konzepterkennung, Negationserkennung, Relationenerkennung), sondern komplexere Tätigkeiten durchführen, wie zum Beispiel:

1. Klassifikation eines Textes (z. B. Gefühlslage des Autors)

2. Übersetzung eines Textes (z. B. von einer Sprache in die andere)

3. Vervollständigung eines Textes (z. B. zur Beantwortung einer Frage)

LLM können so Ähnlichkeiten mit Vorverarbeitungspipelines, Datenbanken, Recommender Systems, Virtuellen Agenten etc. haben – mit dem beeindruckenden Extra, dass sie intuitiv durch Sprache bedienbar sind.

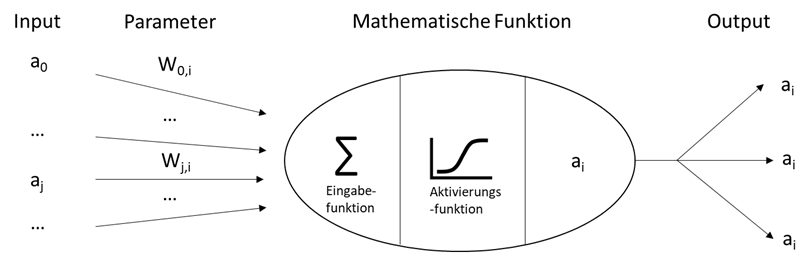

LLM sind eine Weiterentwicklung von Künstlichen Neuronalen Netzen. Künstliche Neuronale Netze wurden bereits 1943 erdacht, sind motiviert durch den Aufbau des menschlichen Gehirns. Ein Künstliches Neuron hat beliebig viele numerische Inputs, berechnet eine mathematische Funktion und liefert einen numerischen Output. Die mathematische Funktion wird über Gewichte (Parameter), eine gewichtete Summe der Inputs und eine lineare Aktivierungsfunktion beschrieben (Russel & Norvig, 2002). Siehe auch Abbildung 1.

Neuronen können zwischengeschaltet zwischen Eingabe und Ausgabe Berechnungen durchführen, d. h. Probleme lösen (z. B. Logik A und B / A oder B). Die Problemlösungsfähigkeit von solchen Neuronalen Netzen ist begrenzt. So kann zum Beispiel das Problem „A und B“ und das Problem „A oder B“ gelöst werden, jedoch nicht das Problem „A exklusives-oder B“.

Daher wird meist Deep Neural Networks genutzt; sie bestehen aus:

1. Vielen (versteckten) Schichten von verknüpften Neuronen (Hidden Layers)

2. Nicht-linearen Aktivierungsfunktionen (Non-linear Activation Functions)

3. Trainingsprozeduren, um die Gewichte zu lernen.

Im einfachsten Fall werden die Neuronen in einer unteren Schicht mit den Neuronen der darüberliegenden Schicht vorwärtsgerichtet und vollständig verknüpft (Feedforward Layer).

Eine Trainingsprozedur vergibt anfängliche Gewichte, vergleicht auf Beispieldaten den berechneten mit dem gewünschten Output und passt daraufhin Gewichte in Abhängigkeit ihres Einflusses an (Rumelhart et al. 1986).

Traditionelle NLP-Applikationen haben Wörter sehr „eindimensional“ genutzt. Ein Wort war in einem Satz oder Text entweder vorhanden, „1“, oder eben nicht, „0“.

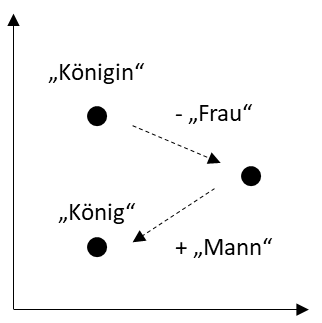

Mittels Deep Learning können Wörter als numerische Vektoren (Embeddings) durch viele Dimensionen repräsentiert werden, die ihre Semantik beschreiben. So liegen in solchen Räumen von Vektoren Wörter mit ähnlicher Bedeutung nah beieinander. Darüber hinaus werden auch relative Eigenschaften erhalten, z. B. wenn man vom Vektor für „Königin“ den Vektor für „Frau“ abzieht und für „Mann“ addiert, erreicht man den Vektor für „König“ (Mikolov et al. 2013). Siehe auch Abbildung 2.

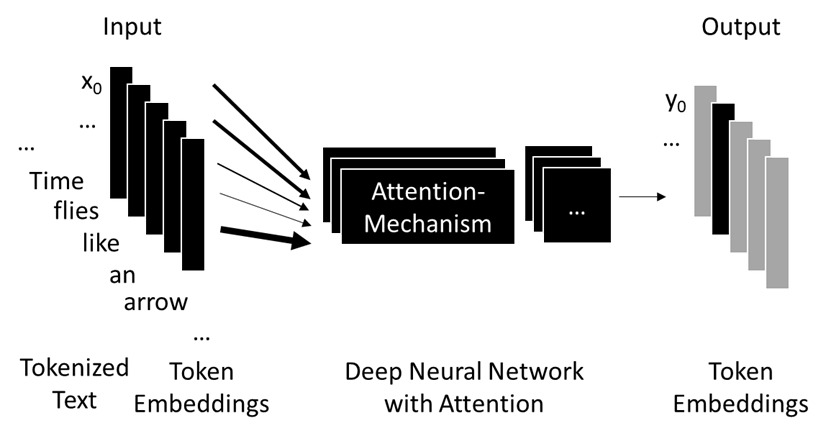

Nicht nur Wörter, sondern auch Buchstaben oder Wortteile können als Vektoren repräsentiert werden (Token). Spezielle Algorithmen teilen dazu Texte entsprechend auf (Tokenizer). Auch Wortreihen, Sätze, Dokumente und beliebige Texte können als Menge an Vektoren repräsentiert werden (Encoder). Anschließend kann die Wahrscheinlichkeit für nachfolgende Texte berechnet werden (Decoder). Dabei kann der Kontext eines Wortes (vorherige und spätere Wörter) berücksichtigt werden (Attention). Besonders effizient durch parallele Berechenbarkeit ist die Architektur der sog. Transformer (Vaswani et al., 2017).

Sprachmodelle, die die Wahrscheinlichkeit von Texten berechnen können, lassen sich so direkt auf beliebigen Textsammlungen trainieren (nicht-supervidiert, weil nicht speziell manuell annotiert). Das Training geschieht zum Beispiel von rechts nach links (Radford et al., 2018) oder bidirektional (Devlin et al., 2018). Input Wörter werden in Wortvektoren umgewandelt, in einem Tiefen Neuronalen Netz bestehend insbesondere aus sog. Attention-Schichten mit anderen relevanten Wörtern vor/hinter dem jeweiligen Wort verglichen. Anschließend erhält man jeweils eine neue Repräsentation, die nun, je nach Anwendung weiter genutzt werden kann, z. B. zur Übersetzung eines Wortes in eine andere Sprache oder zur Vorhersage des nächsten Wortes in einem generierten Text. Siehe auch Abbildung 3.

So hat Deep Learning – ähnlich wie zuvor auf Bildern – beeindruckende Ergebnisse bei Aufgaben zum Textverständnis gezeigt (Ruder, 2018).

Diese Sprachmodelle können anschließend iterativ zum Erstellen von neuen Texten verwendet werden, dazu fragt man das Sprachmodell iterativ nach dem höchstwahrscheinlichsten Wort (Generative Künstliche Intelligenz).

Außerdem sind diese Sprachmodelle eine wirksame Basis (Pretraining), um eine gelernte Semantik auf andere Bereiche zu übertragen (Transfer Learning) und spezielle Fähigkeiten durch gezieltes Training – und damit nachträgliches weiteres Verfeinern der Parameter – zu verbessern (Finetuning). Dieses gezielte Lernen geschieht meist mit manuell annotierten Daten (supervidiert). Je mehr Textdaten (= Datenmenge) und je sorgfältiger das Training (= Rechenpower), desto ausgeprägter zeigen sich diese Eigenschaften (Scaling). So können LLM mit kaum Kontextinformation – wenigen vorangestellten Worten (Prompts) – NLP-Tätigkeiten durchführen (Brown et al., 2020).

LLM wie GPT-2 / 3.5 / 4 (OpenAI), LLaMA (Meta), BERT (Google), Alpaca (Stanford) werden durch verschiedene Einrichtungen mehr oder weniger offen trainiert, ausgetauscht, verfeinert und als Grundlage für weitere Verfeinerungen in verschiedenen NLP-Anwendungen genutzt (Foundation Language Models).

Das offene Sprachmodell LLaMA wurde in seiner größten Version mit 65 Milliarden Parametern (Gewichten) auf 1.4 Billionen Wortteilen mit 2048 A100 GPUs von NVIDIA mit jeweils 80 GB Grafikspeicher in 21 Tagen trainiert. Meta schätzt ab, dass die Entwicklung und das Training insgesamt 2,638 MWh an Energie gekostet haben.

Viele LLM, wie in ChatGPT, werden zudem mit erheblichem manuellen Aufwand auf das Verständnis von Instruktionen und Konversationen (Instruction) trainiert.

Dies geschieht auf zwei Arten: Erstens durch manuell erstellte Paare von Input (Anfrage) und gewünschtem Output (Antwort) zum supervidierten Training. Zweitens durch ein weiteres Sprachmodell, das Antworten auf Anfragen hin bewertet (belohnt). Dieses Belohnungsmodell benötigt wiederum manuell erstellte Paare von Input (Anfrage+Antwort) und Bewertung (bzw. Ranking bei mehreren möglichen Antworten). Das zweite Training kann dann automatisiert durchgeführt werden, indem Anfragen zufällig ausgewählt, dann vom Belohnungsmodell bewertet und zum weiteren Training des Großen Sprachmodells verwendet werden (RLHF, Reinforcement Learning from Human Feedback).

Stärken und Schwächen von LLM

Erst mit der Zeit wird man ein umfassendes Bild von den Stärken und Schwächen von LLM erhalten.

Einige Stärken sind jedoch bereits jetzt klar, wie z. B.:

1. Intuitive Bedienung, durch rein textuelle Eingabe (in beliebigen Sprachen). Sprachmodelle haben die Art, mit Maschinen zu kommunizieren revolutioniert.

2. Beeindruckende Fähigkeit, die Bedeutung von Texten automatisiert zu verstehen (mindestens scheinbar im Sinne eines „Turing-Tests“ bei der Imitation von menschlicher Intelligenz).

3. Beeindruckende Fähigkeit, zusammenhängende Texte zu einem Thema zu erstellen, die auch (meistens) faktisch korrekt, sinnhaft und für Nutzer*innen verständlich sind.

Genauso sind einige Schwächen bereits klar:

Hoher Aufwand, um gezielte Informationen zu speichern. Dazu fehlen Eigenschaften einer Datenbank oder Wissensbasis: Formale Abfragesprache, formales Ausgabeformat, deterministische Ausgaben (bei wiederholter gleicher Eingabe möglicherweise unterschiedliche Ausgaben, da Texte auf Basis von Wahrscheinlichkeiten interpretiert und erstellt werden). Diese Aufgabe wird weiterhin entsprechenden Systemen wie Datenbanken, Suchmaschinen, Data Warehouses und Wissensbasen vorbehalten sein.

Unzuverlässige bis schädliche Ausgaben. Schlimmer noch als unterschiedliche Ausgaben sind bei unvorhergesehenen, untypischen Eingaben inkorrekte, mit Vorurteilen behaftete oder anderweitig ungewollte Ausgaben möglich. Kontrollmechanismen, laufende Tests etc. sind nötig.

Ein begrenzter Kontext, der bei der Interpretation und Erstellung berücksichtigt wird. So kann zum Beispiel GPT-3 ein Kontextfenster von 2048 Wortteilen berücksichtigen. Je länger der Kontext, desto mehr kann es nötig sein, iterative Aufrufe von Großen Sprachmodellen durch übergeordnete Logik zu organisieren.

Wie andere Verfahren zum Maschinellen Lernen sind auch LLM schwer einzusehen. Erklärbarkeit wie bei logischen Schlussfolgerungen und entsprechendes kausales Schließen sind schwer in die notwendigen Wahrscheinlichkeiten zu fassen. Hierzu sind andere Technologien, z.B. Knowledge Graphen, besser geeignet und können ergänzend verwendet werden.

Anwendungsfälle mit (und ohne) Mehrwert

Auch hier gilt, erst mit der Zeit wird man den Nutzen von Großen Sprachmodellen in konkreten Anwendungsfällen bewerten können.

Einige Anwendungsfälle mit Potenzial für LLM:

Im Grunde kann jede NLP-Applikation von LLM profitieren. Zum Beispiel Chatbots, VoiceBots und Virtuelle Agenten. Virtuelle Agenten bestehen häufig aus separaten Komponenten für Natural Language Processing (NLP), für Dialog Management, für Wissensbasis und Natural Language Generation (NLG). Große Sprachmodelle, insbesondere wenn auf gezielten Aufgaben, Interaktionen oder Konversationen trainiert, versprechen einfache Architekturen, allumfassendes Textverständnis und intuitive Interaktionen mit Menschen.

Noch offen ist, wie gut dieser Ansatz sich in Anwendungen bewährt:

Können ausdrückliche Informationen mit höherer Güte, mit höherem Detailgrad, mit weniger Aufwand aus Textdaten (ggf. sogar kombiniert mit Bild, Audio, Video) extrahiert und für Automatisierung genutzt werden?

Können verborgene Informationen, bis hin zu Wissen, frühzeitiger erkannt und mit Mehrwert genutzt werden?

Können in der Interaktion zwischen Mensch und Maschine Tätigkeiten schneller, sicherer, nachvollziehbarer etc. durchgeführt werden? Vielleicht sogar interdisziplinär, workflow- oder prozessübergreifend, und bei vorhandenen Medienbrüchen (von Sprache, über Text, über Video, bis wieder hin zu Sprache).

Es finden sich genügend wenig berücksichtigte Textdaten, notwendiges Wissen sowie suboptimale Workflows und Prozesse in der Industrie, in Behörden, in der Medizin, in der Wissenschaft u. v. m.

Als Beispiel, einige Fragestellungen aus medizinischen Forschungs- und Entwicklungsprojekten bei Empolis:

Die medizinische Aufklärung für Untersuchungen und Behandlungen nimmt viel Zeit und Ressourcen in Anspruch, häufig bleiben noch zu viele Fragen der Patientinnen unbeantwortet.

In den diagnostischen Disziplinen wie der Radiologie werden Befundberichte entweder in Freitext verfasst bzw. diktiert oder Fragebögen ausgefüllt. Je nach Nutzervorliebe werden mehr strukturierte Informationen oder zusammenhängende Texte benötigt, um den schnellen und fehlerfreien Informationsaustausch zwischen medizinischem Personal zu unterstützen.

Viele Entscheidungen zu Nachsorgeoptionen wie Reha, Hausbetreuung etc. werden zu spät getroffen, so dass Entlassungen und die optimale Weiterbehandlung der Patientinnen verzögert werden.

Wichtig bei Anwendungen von LLM sind:

1. Entsprechende Menge an Textdaten (ggf. in unterschiedlichen Sprachen)

2. Experten/Nutzer zum Annotieren von Daten

3. Zugang zu entsprechender Rechenpower

4. Operationale Prozesse für Tests, Deployments, Updates etc.

Sofern diese Voraussetzungen nicht gegeben sind, wird der nachhaltige Mehrwert von LLM wahrscheinlich gering sein.

Es gilt noch näher zu evaluieren, wie gut allgemeine LLM unmittelbar eingesetzt werden können und wo ihre Grenzen liegen. Diese Grenzen können durch Verfeinerungen und gezieltes Training verschoben werden. Hier ist dann der Trade-off zwischen Aufwand und Nutzen relevant.

Vielversprechende Kombinationen von LLM mit anderen Technologien

Der Zugang (On-Premise oder Cloud) und das Verfeinern von LLM wird durch verschiedene Anbieter (z. B. Hugging Face, SpaCy), Plattformen und das Open Source Engagement vieler Menschen vereinfacht (Patel et al., 2023).

Wenn es darum geht, LLM in eigenen Anwendungen einzusetzen, kann dies komplex werden. Das Angebot ist fast unüberschaubar. Je nach Anbieter werden Daten der Kunden (sei es zum Training oder bei Nutzung) wiederum zum Weiterentwickeln der Sprachmodelle verwendet. Aufgrund des Aufwands beim Speichern von Informationen muss man genau bewerten, ob sich der Aufwand lohnt. Qualitätsoptimierung, Tests etc. sind unabdingbar und müssen sorgfältig geplant und umgesetzt werden.

ChatGPT ist ein weiteres eindrucksvolles Beispiel der Leistungsfähigkeit von Deep Learning beim Natural Language Processing (NLP). Sind ChatGPT und andere LLM nun die Lösung für alles? Nein, denn die Ausgangslage bei der Anwendung von Deep Learning hat sich nicht geändert: Für beindruckende Ergebnisse sind große, idealerweise von vielen Menschen aufwendig kuratierte, Datenmengen und große Rechenpower notwendig.

LLM ermöglichen dann weitaus intelligentere Systeme. Jedoch nicht in Isolation, sondern in Kombination mit anderen Systemen: von Datenbanken, über Wissensbasen und Testprozeduren, bis hin zu Knowledge Graphen.

Danksagung

Teile dieser Arbeit wurden durch das BMWi im Projekt MyReportCheck (FKZ: ZF4513702TS8) und das BMBF in den Projekten DIAMED (FKZ: 16SV8322), KIPA (FKZ: 16SV9045) und KIAFlex (FKZ: 16SV9004) unterstützt. Vielen Dank an Marian Thull, Isabel Schmittel, Máté Maros, Ralph Traphöner, Krzysztof Janiszewski und Nico Hermeling für wertvolles Feedback zu einem Entwurf des Blogartikels.

Referenzen

Russell, S. and P. Norvig. 2002. Artificial Intelligence: A Modern Approach, 2nd edition. Prentice Hall.

Mikolov, T., Chen, K., Corrado, G., & Dean, J. (2013). Efficient estimation of word representations in vector space. 1st International Conference on Learning Representations, ICLR 2013 – Workshop Track Proceedings, 1–12.

Vaswani, Ashish, et al. „Attention is all you need.“ Advances in neural information processing systems 30 (2017).

Radford, Alec, et al. „Improving language understanding by generative pre-training.“ (2018).

Rumelhart, David E., Geoffrey E. Hinton, and Ronald J. Williams. „Learning representations by back-propagating errors.“ nature 323.6088 (1986): 533-536.

Devlin, Jacob, et al. „Bert: Pre-training of deep bidirectional transformers for language understanding.“ arXiv preprint arXiv:1810.04805 (2018).

Brown, Tom, et al. „Language models are few-shot learners.“ Advances in neural information processing systems 33 (2020): 1877-1901.

Ruder, Sebastian “The State of Transfer Learning in NLP”. Blog ruder.io, https://www.ruder.io/state-of-transfer-learning-in-nlp/ 2019.

Patel, Dylan et al. „Google „We Have No Moat, And Neither Does OpenAI“, Shared Google Document. 2023.