7 Gründe, warum man LLMs nicht mit den eigenen Daten trainieren sollte

Zurück zum BlogNeuronale Sprachmodelle wie ChatGPT werden aktuell von vielen Unternehmen auf Ihren Einsatz mit den eigenen Daten durchleuchtet. Für spezifische Anforderungen mag es verlockend sein, diese Modelle mit eigenen Daten zu feintunen, d. h. das Sprachmodell wird mit den unternehmenseigenen Daten trainiert. Doch gerade wenn es um das Thema Wissensmanagement geht, aber auch darüber hinaus, bringt dieses Vorgehen erhebliche Nachteile mit sich.

1. Schwierige Pflege der Daten

Einmal in die „Black Box“ eines Sprachmodells integriert, ist es nahezu unmöglich, Daten punktuell zu ändern oder zu korrigieren. Im Gegensatz zu traditionellen Datenbanken, bei denen Änderungen direkt und transparent vorgenommen werden können, verschwinden Daten in Sprachmodellen und lassen sich nicht einzeln bearbeiten oder aktualisieren.

Beispiel: Stellen Sie sich eine Bank vor, die ein Sprachmodell nutzt, um automatisierte Kundenanfragen zu beantworten. Das Modell wurde mit Daten über eine bestimmte Gebühr trainiert. Wenn die Bank diese Gebühr in ihren Systemen und Dokumenten ändert, kann das Sprachmodell nicht einfach aktualisiert werden, um die neue Information widerzuspiegeln. Es sind Vorgehensweisen nötig, die ausreichend Kenntnisse mit KI-Verfahren voraussetzt, um die alte Information „rauszulöschen“ und die neuen anzutrainieren. Kunden könnten daher falsch informiert werden, was zu Verwirrung und möglichen finanziellen Konsequenzen führt.

2. Neutraining bei Erweiterung und Updates

Ein bedeutendes Problem ist die Notwendigkeit, das Modell bei jeder Erweiterung von Daten neu zu trainieren. Dies ist nicht nur zeitaufwendig und kostspielig, sondern kann auch zu Inkonsistenzen in den Trainingsdaten führen, wenn nicht alle Änderungen gleichzeitig berücksichtigt werden. Zudem wird es unmöglich sein flüchtige oder sich ständig ändernde Informationen zu berücksichtigen.

Beispiel: Ein Pharmaunternehmen nutzt ein Sprachmodell, um Fragen zu Medikamenten zu beantworten. Wird ein neues Forschungsergebnis veröffentlicht, das die Nebenwirkungen eines Medikaments betrifft, muss das gesamte Modell neu trainiert werden, um diese neue Erkenntnis zu integrieren. Dieser Prozess kann Wochen dauern und währenddessen könnten Patienten unvollständige oder veraltete Informationen erhalten.

3. Halluzinationen sind schwer beherrschbar

Sprachmodelle können dazu neigen, Informationen zu „halluzinieren“, also Aussagen zu generieren, die nicht auf den Trainingsdaten basieren. Dies kann zu Fehlinformationen führen, die in einem Wissensmanagement-System besonders kritisch sind. Die Kontrolle und Verifizierung solcher Fehlinformationen ist aufwendig und stellt ein erhebliches Risiko dar.

Beispiel: Ein Touristikunternehmen setzt ein Sprachmodell ein, um Reiseempfehlungen zu geben. Ein Kunde fragt nach sicheren Reisezielen, und das Modell „halluziniert“, dass ein bestimmtes Gebiet sicher ist, obwohl es aktuell politische Unruhen gibt. Der Kunde könnte aufgrund dieser falschen Information eine Reise buchen und in Gefahr geraten.

4. Mangel an Transparenz

Ein weiteres Problem beim Feintuning von Sprachmodellen ist die mangelnde Transparenz darüber, wie Entscheidungen getroffen oder Informationen generiert werden. Denn in der Natur der Technologie liegt die absolute Unfähigkeit, genau zu rekonstruieren, woher die Information stammte. Genau das macht den Einsatz für wichtige geschäftliche oder organisatorische Entscheidungen nahezu unmöglich. Kann keine Auskunft darüber gegeben werden, aus welcher Quelle eine Aussage stammt, verlieren Unternehmen die Kontrolle über die Informationen, die ausgegeben werden – und kommen damit sehr wahrscheinlich in Compliance-Schwierigkeiten.

Beispiel: Ein Maschinenbauunternehmen verwendet ein Sprachmodell, um technische Fragen zu seinen Produkten automatisch zu beantworten. Ein Kunde fragt nach den Spezifikationen eines bestimmten Maschinenteils, da er überlegt, es in seinem eigenen Produktionsprozess zu verwenden. Das Sprachmodell liefert eine Antwort, die besagt, dass dieses Teil einer Temperatur von bis zu 500 Grad Celsius standhalten kann.

Der Kunde, ohne die genaue Quelle oder den Kontext dieser Information zu kennen, verlässt sich auf diese Angabe und setzt das Teil in einem Hochtemperaturprozess ein. Später stellt sich heraus, dass das Modell die Information falsch interpretiert hat und das Teil tatsächlich nur für Temperaturen bis zu 400 Grad Celsius ausgelegt ist. Dies führt zu einem Ausfall in der Produktion des Kunden und möglicherweise zu erheblichen Schäden, sowohl finanziell als auch in Bezug auf die Sicherheit.

5. Unvorhersehbare Kosten

Das Feintuning von Modellen, insbesondere von großen, erfordert erhebliche Rechenleistung. Dies kann zu unerwarteten und steigenden Kosten führen, insbesondere wenn regelmäßige Aktualisierungen oder Neutrainings erforderlich sind.

Erweitertes Beispiel für ein Maschinenbauunternehmen: Ein Maschinenbauunternehmen, nennen wir es „TechMach GmbH“, möchte ein Sprachmodell nutzen, um Kundenanfragen hinsichtlich technischer Spezifikationen, Wartungshinweisen und Bestellinformationen für seine Maschinenteile zu beantworten. Da TechMach GmbH spezifische und einzigartige Produkte hat, entscheiden sie sich für ein Feintuning eines vortrainierten Sprachmodells mit eigenen, unternehmensspezifischen Daten.

Kostenfaktor 1: Datenbereinigung und -vorbereitung

Bevor sie überhaupt mit dem eigentlichen Training beginnen, muss TechMach GmbH ihre Daten sichten, bereinigen und formatieren. Für diesen Schritt nehmen sie einen Data Scientist und zwei Techniker in Anspruch, die zusammen einen Monat daran arbeiten. Angenommen, der Data Scientist verdient 70€/Stunde und die Techniker jeweils 50€/Stunde, ergibt das Kosten von etwa 40.000€ allein für diesen Schritt (bei einer 40-Stunden-Woche).

Kostenfaktor 2: Rechenleistung und Speicher

Das Feintuning erfordert leistungsfähige GPUs oder TPUs. Je nach Größe des Modells und Umfang der Daten kann dies schnell teuer werden. Ein einfaches Feintuning kann bereits mehrere tausend Euro kosten. Ein umfangreicheres Projekt kann jedoch leicht in den sechsstelligen Bereich gehen. Nehmen wir an, TechMach GmbH würde für ihr Vorhaben 50.000€ an Rechen- und Speicherkosten veranschlagen.

Kostenfaktor 3: Fachkräfte und Zeit Ein Team von zwei Maschinenlern-Experten, die jeweils 80€/Stunde verdienen, arbeitet zwei Monate am Training und der Optimierung des Modells. Das sind weitere 128.000€.

Kostenfaktor 4: Tests und Anpassungen

Nachdem das Modell trainiert wurde, muss es getestet und möglicherweise nachjustiert werden. Dieser Zyklus kann sich mehrmals wiederholen. Angenommen, dieser Prozess dauert einen weiteren Monat und bindet zusätzliches Personal (Tester, Ingenieure, etc.) ein, könnten hier nochmals rund 50.000€ anfallen.

Kostenfaktor 5: Unvorhergesehene Probleme

Wie bei jedem technischen Projekt können unerwartete Probleme auftreten, sei es durch Fehler in den Daten, durch technische Probleme oder durch Schwierigkeiten bei der Integration des Modells in die bestehende IT-Infrastruktur. Ein solcher ungeplanter Aufwand könnte leicht weitere 20.000€ oder mehr kosten.

In Summe könnten die Kosten für das Feintuning in diesem Beispiel für TechMach GmbH also bei über 240.000€ liegen – und das ist noch eine vorsichtige Schätzung. Es wird deutlich, dass die Kosten für das Feintuning von Sprachmodellen schnell steigen können und daher sorgfältig geplant und budgetiert werden müssen.

6. Kein Rollen-Rechte-Prinzip bei Sprachmodellen realisierbar

In vielen IT-Systemen, insbesondere in solchen, die für geschäftliche Zwecke eingesetzt werden, ist das Rollen- und Rechteprinzip von entscheidender Bedeutung. Es legt fest, wer auf welche Informationen zugreifen und welche Aktionen ausführen darf.

Bei Sprachmodellen ist es jedoch nahezu unmöglich, ein solches differenziertes Zugriffsmanagement zu implementieren. Wenn bestimmte Informationen in das Modell integriert sind, kann grundsätzlich jeder, der Zugriff auf das Modell hat, auch diese Informationen abrufen.

Noch problematischer wird es, wenn man sich der sogenannten „Prompt Injection Attacks“ bewusst wird. Angreifer können durch geschickt formulierte Eingabeaufforderungen (Prompts) das Modell dazu bringen, Informationen preiszugeben oder in einer bestimmten, unerwünschten Weise zu reagieren. Das bedeutet, selbst wenn versucht wurde, durch Feintuning bestimmte Rollen und Rechte im Modell zu etablieren, können diese durch solche Angriffe umgangen werden.

7. Keine gezielte Suche möglich

Während traditionelle Datenbanksysteme es erlauben, gezielt nach bestimmten Daten oder Informationen zu suchen, basieren Sprachmodelle auf probabilistischen Algorithmen und liefern Antworten basierend auf Mustern in den Trainingsdaten.

Das Fehlen einer gezielten Suchfunktionalität kann zu Ineffizienzen führen, insbesondere wenn schnelle und genaue Antworten erforderlich sind. Es kann auch das Risiko von Missverständnissen und Fehlern erhöhen, da das Modell nicht immer den genauen Kontext oder die Absicht hinter einer Anfrage erkennen kann.

Die Alternative: RAG (Retrieval Augmented Generation)

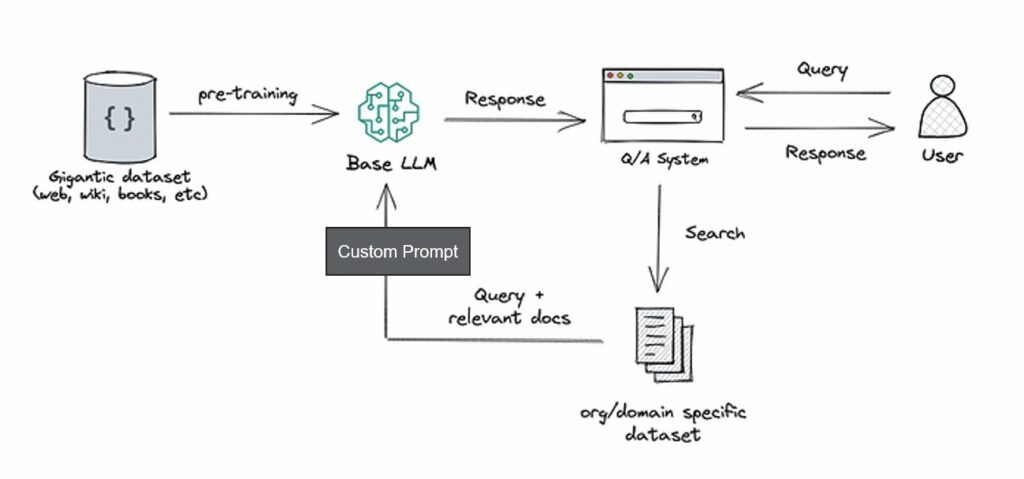

RAG (Retrieval Augmented Generation) ist eine neuartige Methode zur Informationsabrufung und -erzeugung, die sowohl Techniken des maschinellen Lernens als auch traditionelle Suchmaschinenkonzepte integriert. Im Kern kombiniert es die Stärken von Sprachmodellen mit denen von Informationsabrufsystemen, um genaue und relevante Antworten auf Benutzeranfragen zu liefern.

Im Gegensatz zum Feintuning bietet RAG eine flexible und effiziente Lösung für Wissensmanagement-Aufgaben. RAG kombiniert die Vorteile von Sprachmodellen und traditionellen Retrieval-Systemen. Anstatt Wissen direkt in das Modell zu integrieren, sucht RAG in einer Datenbank nach relevanten Informationen und generiert darauf basierend Antworten.

Das Prinzip ist schnell erläutert:

1. Eine Anfrage wird von einem Q/A-System (bspw. Wissensmanagementsystem) entgegengenommen

2. Das Q/A-Systems filtert intelligent passende Inhalte aus dem Datenbestand. Je intelligenter und besser die Suchtechnologien & -methoden sind, desto besser ist die spätere Antwortqualität.

3. Die Inhalte werden in Textform überführt

4. (Optional) Bei Bedarf kann dem Sprachmodell durch einen Custom Prompt eine gewünschte Rolle gegeben werden. (bspw. um Tonus, Ansprache und Antwortlänge vorzugeben)

5. Der Text wird zusammen mit dem Custom Prompt und der ursprünglichen Eingabe an ein Sprachmodell übergeben.

6. Das Sprachmodell generiert eine Antwort mit dem Wissen aus den gefilterten Inhalten

7. Bei weiteren Fragen wird der Kontext gehalten, bei Kontextänderungen wird eine neue Anfrage abgefeuert und wieder bei Schritt 1 gestartet

Somit lässt sich mit einem Sprachmodell so reden, als hätte es deine Daten gelesen, ohne je damit trainiert worden zu sein.

RAG stellt eine revolutionäre Verschmelzung von kreativer Sprachgenerierung und präziser, zielgerichteter Datenrückgewinnung dar. Um das volle Potenzial dieses Systems zu erkennen, sollten wir uns näher mit seinen zentralen Vorteilen befassen:

Direkte und transparente Aktualisierung der Datenquelle: Während bei herkömmlichen Systemen Datenänderungen oft komplexe Neukonfigurationen oder sogar manuelle Eingriffe erfordern, ermöglicht RAG eine einfache und direkte Aktualisierung der Daten. Du könntest stets in Echtzeit auf deine Inhalte zugreifen, selbst wenn diese gerade geändert wurden.

Keine Notwendigkeit des Neutrainings bei Datenänderungen: Das Training großer neuronaler Netzwerke kann zeitaufwendig und teuer sein. Mit RAG entfällt die Notwendigkeit, das gesamte System bei jeder kleinen Datenänderung neu zu trainieren. Stattdessen wird das zugrunde liegende Modell durch den fortlaufenden Informationsabruf kontinuierlich aktualisiert und angepasst.

Bessere Kontrolle über die generierten Antworten: Während Sprachmodelle oft als „Black Boxes“ gelten, bei denen der Ursprung und der Kontext der Antworten schwer zu fassen sind, bietet RAG eine klare Struktur, die es Benutzern ermöglicht, die Herkunft der Antworten zu verstehen und nachzuvollziehen. Wenn Antworten generiert werden, kann stets genannt werden, aus welchem Dokument die Inhalte stammen (und direkt verlinkt werden).

Darüber hinaus sind auch alle genannten Themen, die beim Fine-Tuning ein Problem darstellen vom Tisch. Noch nicht erwähnt, aber explizit genannt sollte der große Vorteil der Datensicherheit bei diesem Prinzip sein: es ist nicht nötig ein fremdgehostetes Sprachmodell mit deinen Daten zu trainieren. Nimmt man die Datenbasis weg, ist das Sprachmodell nicht mehr auskunftfähig. So bleibst du Herr über deine Daten.

Fazit

Insgesamt betrachtet stellt sich RAG nicht nur als eine sinnvolle Alternative zum Feintuning von Sprachmodellen dar, sondern in vielen Anwendungen als überlegen. Es handelt sich um eine Technologie, die sowohl die kreative Potenz von Sprachmodellen als auch die Präzision und Zuverlässigkeit von Wissensmanagementsystemen nutzt. Das Ergebnis? Eine state-of-the art Lösung, die vielleicht bald die Art und Weise, wie wir Informationen abrufen, maßgeblich prägen wird.

Ein Beitrag von Roman Senger, Channel Sales Manager